中国AI算力产业,正迎来发展的关键节点。

随着AI大模型及应用的加速落地,算力基础设施建设的重要性与日俱增,但传统服务器堆叠的模式会带来算力利用率低、训练中断等挑战。

为了解决相关难题,在近日的华为全联接大会上,华为宣布推出创新的超节点架构。华为董事、ICT BG CEO杨超斌表示,华为超节点产品可以满足大型数据中心、企业级数据中心和小型工作站等全场景算力需求,惠及每个行业。

硬件之外,中国AI算力产业长期面临生态建设滞后的挑战。中国工程院院士、清华大学计算机系教授郑纬民曾表示,近两年我们国内的AI芯片取得了很大进步,但问题在生态不太好,现在建成的万卡系统大多数都不好用。

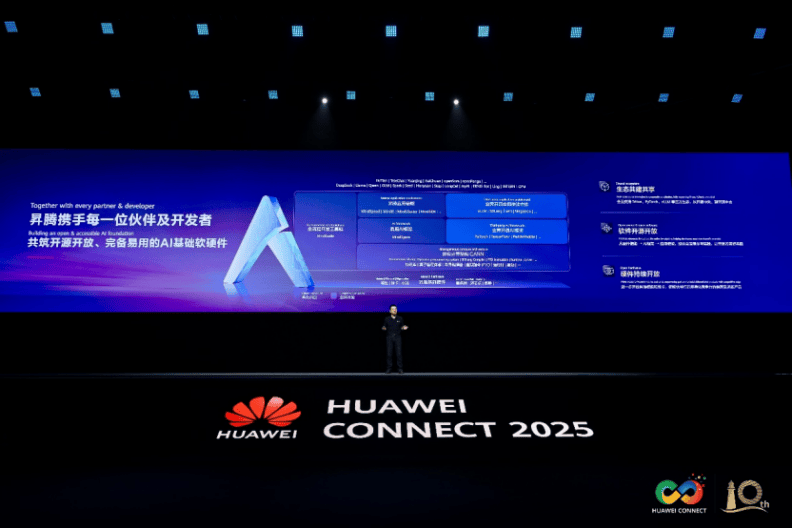

生态是用出来的,作为AI芯片的领跑者,华为将发展生态提到了前所未有的战略高度。同样在华为全联接大会2025上,据华为常务董事汪涛透露,未来5年,华为计划每年投入150亿人民币生态发展费用、1500P开源社区算力,并投入15000人进行生态平台开发与支持。

具体来说,针对计算产业,华为宣布软件全面开源开放的策略。今年,华为新增开源CANN、Mind系列应用使能套件、openPangu等,同时支持业界主流的开源社区和开源项目,支持用户深度挖掘昇腾潜力,加快自主创新。

在AI芯片领域,英伟达之所以占据着如此强大的统治地位,是因为它构筑起了完整的生态壁垒。如果用户想迁移至其他品牌,需进行不小的成本投入。而现如今随着昇腾生态的崛起,毫无疑问为所有企业提供了更值得信赖的“新选择”。

英伟达CUDA封闭,华为CANN开源开放

众所周知,在底层硬件上,昇腾已经基于开放的模组和标卡,使能伙伴打造了200多款硬件产品,满足各场景差异化需求。

在硬件开放的基础上,华为这次全面开源开放CANN,标志着这家科技巨头在构建开放AI生态战略上迈出了极为关键的一步。

CANN的全称是“神经网络异构计算架构”(Compute Architecture for Neural Networks),它的角色,是把底层昇腾芯片和上层AI训练框架(如PyTorch、TensorFlow、MindSpore等)连接起来的桥梁,让开发者不用关心芯片细节就能调用底层算力。

与CANN发挥类似作用的,还有英伟达的CUDA、AMD的ROCm、摩尔线程的MUSA等等。CUDA让开发者可以更高效发挥GPU性能、降低使用成本,与GPU和NVlink一起构成了英伟达的核心护城河。

CANN作为昇腾AI基础软硬件平台的核心组件,于2018年推出,目前已经迭代至8.0版本。相比CUDA闭源,此次CANN开源开放,无疑加速了CANN生态圈建设,开发者也可以降低对CUDA生态的被迫依赖。

据了解,开发者普遍希望能够更加灵活的调用CANN的各层级能力,自主的性能调优、问题定位以及算法创新。为此,华为通过分层解耦,支持开发者从模型、算子、内核以及底层资源按需调用。

比如,昇腾通过图模式开发,可实现整图编译与下发,降低调度开销;也可直接调用ATB等领域算子,完成模型的性能优化;也支持C、C++、Python和模板库等多种编程方式,满足开发者的各种习惯;同时,华为开源了底层Runtime能力,开发者可以细粒度使用硬件资源。

为更好地匹配开发需求,CANN构建了完备的编程体系,提供Ascend C编程语言和CATLASS模板库。同时,通过开放AscendNPU IR,支持Triton、TileLang、FlagTree等Python前端的开源编程框架,可以让开发者快速验证创新的想法。

CANN开源开放筹备了两年多,是今年华为发展昇腾生态最核心的“一步棋”。但下定如此大的决心,将核心知识资产公开,对于以通信起家的华为并不容易。

华为轮值董事长徐直军曾透露,CANN全面开源开放,其实是在很多客户的促进下形成的。“没有客户的促进,我们的研发团队感觉还好得很,而且感觉什么都给客户做好了挺好的。”

据他表示,华为习惯把源代码捂得死死的,因为是核心资产。CANN全面开源开放,需要说服大家到底从哪里挣钱。最终,大家达成一致是打算变现靠昇腾硬件,开源开放是促进硬件规模和硬件的普遍使用,大家都用了、卖得多了,开源开放的钱就挣回来了。

计算产业是生态型产业,开源才能把生态做大。面对CUDA生态的强大惯性,华为坚持发展并开源CANN,不仅能让昇腾更好用、更易用,也是在推动整个计算产业的加速前进。

CUDA生态已经发展了十几年,如今基于昇腾NPU和昇腾CANN技术生态所能实现的AI应用性能,已经能够看齐甚至超越CUDA,已经展现出强大的竞争力。

一场关于生态话语权的争夺战

除了开源开放自己的产品技术,昇腾也在不断加强与业界开源社区、开源项目的合作。

AI框架是人工智能的操作系统,而PyTorch是全球最知名的AI框架之一,由Meta推出,在2016年已经开源。PyTorch之外,谷歌的TensorFlow、华为的昇思MindSpore也都已经开源。

早在2023年,PyTorch基金会就正式宣布华为作为Premier会员加入,这也是中国首个、全球第十个PyTorch基金会最高级别会员,这意味着华为对PyTorch的技术贡献颇大。

为什么自己已经有了昇思MindSpore,华为也会同样加大对PyTorch的投入力度呢?这是因为,很多开发者之前就在PyTorch上构建业务,与成熟的开源社区共建生态,可以大幅降低客户的使用门槛。

vLLM是最受开发者欢迎的推理引擎之一,从去年下半年开始,昇腾便开始与vLLM开展技术和生态合作。vLLM社区新版本发布即支持昇腾,为开发者提供更多选择。昇腾团队还协助vLLM社区开发了硬件后端的插件化特性,降低社区对后端支持的维护成本。

具体来说,在最新版本的vLLM中,开发者可以基于昇腾与vLLM的全链功能,一条命令实现底层应用的无感切换,同时通过插件化的解决方案获得混合并行、动态调度等更多高阶特性。

与此同时,昇腾新特性、组件和开发计划等也都将在PyTorch、vLLM、VeRL、SGLang、Triton等开源社区上首发,让开发者第一时间获取到最新技术。

此外,为了让开发者快速掌握昇腾开发技能,华为在昇腾社区提供完备的知识体系,比如大家关心的模组参考设计、aclNN算子开发指导、CATLASS开发指导等10多个场景化文档和100多专题课程。

华为还会提供分层赋能,比如DR辅导、线下沙龙和线上直播等,让每一位开发者都能按需获取技术指导,激发开发者技术创新。

目前,昇腾已有80多家硬件伙伴打造了200多款产品;昇腾主导开源的60多个项目,累计有6500多名核心贡献开发者。昇腾也在50多个开源社区和开源项目中积极贡献,累计贡献37万行代码。

开源的核心是共享,开放的本质是共赢。无论是加大对业界主流的开源社区和开源项目的支持力度,还是更积极开放地建设昇腾社区、培养创新人才,都体现了华为下定决心开放生态,而不是走英伟达的封闭路线。

这一系列举措的背后,本质实际上是生态话语权的争夺。选择开源开放,意味着华为能联合更多伙伴一起制定人工智能的行业标准,共享创新成果。

为何华为要如此坚定发展昇腾AI生态?徐直军曾解释到,如果我们一直投资去兼容CUDA,却无法使用最新版本,如果哪天CUDA生态兼容不了怎么办?现在我们的AI,从达芬奇架构到昇腾芯片、再到一切包括所有软件生态,都不依赖西方的生态和供应链。所以长远来考虑的话,要把生态构建起来。

目前在硬件层面上,华为通过超节点+集群的方式,应对芯片制造工艺受限、单片芯片性能不足的挑战,实现了算力的强大供给。

相对来说,AI生态的建设是一个更加缓慢的过程,需要千千万万开发者、合作伙伴一起努力。有数据显示,英伟达聚集的开发者达800万,而昇腾还不到100万。

尽管道路漫长且充满挑战,但正如徐直军所说,只要大家心往一处想,都来使用,国内算力生态一定会发展起来。